emulador de robots.txt: Bloquear URL basándose en las reglas de robots.txt

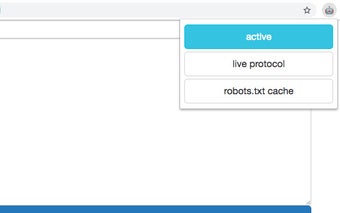

robots.txt emulator es una extensión de Chrome que permite a los usuarios bloquear URLs basándose en las reglas definidas en el archivo robots.txt de hosts específicos. Esta extensión está diseñada para proporcionar una forma conveniente de ver qué URLs están siendo bloqueadas, modificar el archivo robots.txt en tiempo real y aprovechar su compatibilidad con Chrome 41.

Con robots.txt emulator, los usuarios pueden evitar fácilmente el acceso a ciertas URLs según las reglas establecidas en el archivo robots.txt. Esto puede ser útil para los propietarios de sitios web que desean controlar el acceso de los rastreadores de motores de búsqueda a páginas o archivos específicos. La extensión proporciona una interfaz fácil de usar que permite a los usuarios ver y editar el archivo robots.txt sobre la marcha, lo que facilita la personalización de las reglas según sus necesidades.

Una de las características destacadas de robots.txt emulator es su compatibilidad con Chrome 41. Esto significa que los usuarios que utilizan versiones anteriores de Chrome aún pueden aprovechar la funcionalidad de esta extensión. Ya sea que seas propietario de un sitio web o desarrollador, robots.txt emulator ofrece una solución conveniente para gestionar el acceso a URLs basado en las reglas de robots.txt.